Избавленный от посторонних глаз, сайт может быть защищен от роботов поисковых систем. Закрыть сайт от индексации может быть полезным во многих случаях, например, если вы разрабатываете новый веб-проект, который еще не готов для публичного использования. В этом кратком руководстве мы рассмотрим несколько способов, как легко ограничить доступ поисковым машинам к вашему сайту.

Первый способ — использование файла robots.txt. Это текстовый файл, который можно разместить на корневом уровне вашего сайта и указать инструкции для роботов поисковых систем. Он сообщает поисковому роботу, какие страницы или каталоги следует индексировать, а какие — исключать. Для создания файла robots.txt достаточно открыть текстовый редактор и внести нужные инструкции.

Как закрыть сайт от индексации: краткое руководство

Если у вас есть необходимость закрыть свой сайт от индексации поисковыми системами, вам потребуется несколько простых шагов для достижения этой цели. Ниже приведено краткое руководство, которое поможет вам выполнить эту задачу.

1. Создайте файл robots.txt. Этот файл должен располагаться в корневой директории вашего сайта и содержать правила для роботов поисковых систем. Вам нужно будет добавить директиву Disallow с указанием страниц и папок, которые вы хотите исключить из индексации. Например:

User-agent: * Disallow: /страница-1/ Disallow: /папка-1/

2. Добавьте мета-тег noindex на страницы, которые вы хотите исключить из индексации. Это можно сделать, добавив следующий код в секцию <head> каждой страницы:

<meta name="robots" content="noindex">

3. Добавьте мета-тег noindex на внутренние ссылки, которые ведут на страницы, которые вы хотите исключить из индексации. Например, если у вас есть ссылка на страницу «страница-1» в меню сайта, вам нужно добавить следующий код к этой ссылке:

<a href="/страница-1/" rel="nofollow noindex">Страница 1</a>

После выполнения этих шагов ваш сайт будет закрыт от индексации поисковыми системами. Однако, помните, что вы не сможете полностью гарантировать, что ваш сайт не будет проиндексирован, так как каждая поисковая система имеет свои алгоритмы и методы индексации. Поэтому регулярно проверяйте индексацию своих страниц и обновляйте правила в файле robots.txt, если это необходимо.

Использование файла robots.txt

Основной целью файла robots.txt является предотвращение индексации и сканирования определенных частей сайта, которые, по каким-либо причинам, могут быть желательно скрыть от поисковиков. Например, речь может идти о частях сайта, содержащих чувствительную информацию, временных разделах, или динамически создаваемых страницах, которые, возможно, содержат дубликаты контента, и т.д.

В файле robots.txt можно использовать следующие директивы для указания инструкций поисковым роботам:

User-agent — позволяет указать для какого конкретного поискового робота предназначается директива;

Disallow — задает список файлов или папок, которые не должны индексироваться;

Allow — определяет список файлов или папок, которые поисковый робот имеет разрешение сканировать и индексировать;

Host — определяет каноническое имя хоста;

Sitemap — указывает на расположение файла sitemap.xml, который содержит информацию о структуре сайта.

Например, для того чтобы запретить индексацию всем поисковикам на сайте, необходимо добавить следующую директиву в файл robots.txt:

- User-agent: *

- Disallow: /

Таким образом, правильное использование файла robots.txt может помочь веб-мастерам контролировать доступ поисковых роботов к своим сайтам и защитить чувствительную информацию от индексации и сканирования.

Установка мета-тегов «noindex» и «nofollow»

Мета-тег «noindex» указывает поисковым роботам не индексировать страницу. Это означает, что страница не будет отображаться в поисковых результатах. Использование этого тега может быть полезным для страниц с дублирующимся контентом или страниц, которые не предназначены для публичного доступа. Для установки мета-тега «noindex» необходимо добавить следующий код в раздел <head> каждой страницы:

<meta name="robots" content="noindex">

Мета-тег «nofollow» указывает поисковым роботам не переходить по ссылкам на странице. Это особенно полезно в случаях, когда веб-мастеры не хотят, чтобы поисковые системы следовали по ссылкам на определенных страницах. Для установки мета-тега «nofollow» необходимо добавить следующий код в раздел <head> каждой страницы:

<meta name="robots" content="nofollow">

Использование заголовка HTTP «X-Robots-Tag»

Для закрытия сайта от индексации поисковыми системами можно использовать заголовок HTTP «X-Robots-Tag». Этот заголовок позволяет управлять поведением поисковых роботов на сайте и указывать им, что нужно делать с содержимым страницы.

Чтобы закрыть сайт от индексации, нужно добавить следующую строку в коде вашей веб-страницы:

<meta name="robots" content="noindex">Эта строка сообщает поисковым системам, что страницу не нужно индексировать. Таким образом, поисковые роботы не будут сканировать и индексировать содержимое страницы, и оно не появится в результатах поиска.

Существует несколько параметров, которые можно использовать вместе с заголовком «X-Robots-Tag» для более точной настройки поведения поисковых роботов. Например, вы можете указать, что нужно индексировать только заголовок страницы, а остальное содержимое должно быть исключено из индексации:

<meta name="robots" content="noindex, follow">Эта строка указывает поисковым системам не индексировать страницу, но продолжать следовать по ссылкам на этой странице. Таким образом, поисковые роботы продолжат индексировать другие страницы, на которые есть ссылки с этой страницы. Это может быть полезно, например, если вы хотите закрыть от индексации только определенные разделы вашего сайта, но продолжить индексацию других разделов.

Использование мета-тега «noarchive»

Этот мета-тег полезен в тех случаях, когда владелец сайта хочет контролировать доступность информации, представленной на странице, и не желает, чтобы эта информация была доступна через поисковую выдачу или кэш поисковых систем.

Для использования мета-тега «noarchive» в HTML-коде страницы нужно добавить следующую строку:

<meta name="robots" content="noarchive">

Этот мета-тег может быть добавлен в раздел <head> страницы и применяется ко всему ее содержимому. Он может также использоваться совместно с другими мета-тегами, такими как «noindex» и «nofollow», чтобы более точно задать правила индексации и обхода ссылок поисковыми системами.

Использование мета-тега «noarchive» может быть полезным в различных ситуациях, таких как защита конфиденциальной информации, временное сокрытие страницы от поисковиков, исправление проблем с дубликатным контентом и другие.

Использование файла .htaccess для закрытия сайта от индексации

Для того чтобы закрыть сайт от индексации, необходимо внести определенные правила в файл .htaccess. Одним из наиболее эффективных методов является использование правила «отказа от индексации» (протокола robots.txt) .

Чтобы добавить правило отказа от индексации на сайт, нужно внести следующие строки в файл .htaccess:

- # Запрет индексации всего сайта:

- Options All -Indexes

После внесения указанных строк в файл .htaccess, поисковые системы не будут индексировать сайт и не будут отображать его в результатах поиска. Таким образом, сайт будет оставаться недоступным для пользователей, использующих поисковые системы для поиска информации.

Использование блокировки по IP-адресу

В некоторых ситуациях может возникнуть необходимость закрыть доступ к вашему сайту для определенных IP-адресов. Это может быть полезно, например, когда ваш сайт подвергается массовым атакам со стороны конкретного диапазона IP-адресов или когда вы хотите предотвратить доступ к сайту из определенных стран.

Для блокировки доступа по IP-адресу можно использовать специальные конфигурационные файлы веб-сервера. При этом нужно указать диапазон IP-адресов, которые вы хотите заблокировать, и настроить сервер таким образом, чтобы он игнорировал запросы от этих адресов.

Пример использования блокировки по IP-адресу

Допустим, вы хотите заблокировать доступ к вашему сайту для IP-адресов из диапазона 192.168.0.1-192.168.0.100. Для этого вам понадобится изменить конфигурационный файл веб-сервера. В случае использования Apache это может быть файл .htaccess или httpd.conf. В этом файле вам нужно добавить следующие строки:

<IfModule mod_authz_core.c>

<RequireAll>

<Require not ip 192.168.0.1/24</Require>

</RequireAll>

</IfModule>

После сохранения изменений и перезагрузки веб-сервера, доступ к вашему сайту будет заблокирован для IP-адресов из указанного диапазона. Обратите внимание, что указанный пример подразумевает использование Apache в качестве веб-сервера и модуля mod_authz_core.c.

Использование сервисов для закрытия сайта от индексации

Есть несколько специальных сервисов, которые помогают владельцам сайтов закрыть свои страницы от индексации поисковыми системами. Использование таких сервисов может быть полезно в следующих случаях:

- Если вам нужно временно скрыть сайт от публичного доступа, например, во время проведения реконструкции или изменения внешнего вида.

- Если вы хотите закрыть определенные страницы сайта от индексации поисковыми системами, чтобы они не отображались в результатах поиска.

Сервисы для закрытия сайта от индексации обычно предоставляют такие возможности, как:

- Установка файла robots.txt, чтобы указать поисковым системам правила индексации или исключения для отдельных страниц.

- Добавление мета-тега noindex на страницы, которые не должны попадать в поисковые результаты.

- Предоставление возможности временно или постоянно блокировать доступ к сайту по IP-адресам или другим параметрам.

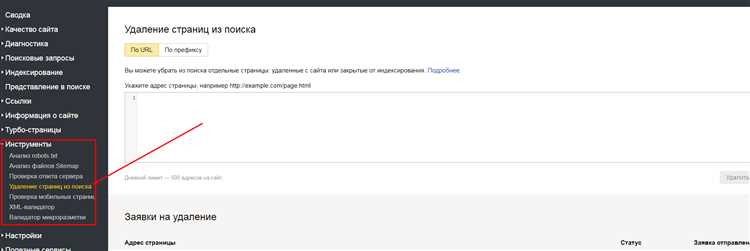

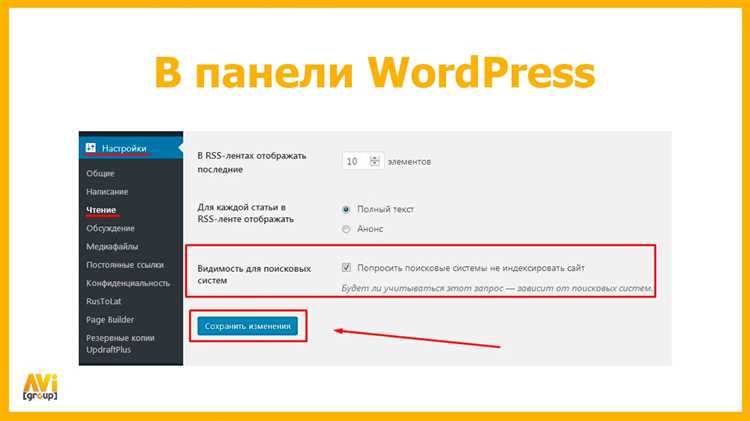

Один из таких сервисов - Google Search Console, предоставляемый самой поисковой системой Google. Он позволяет управлять настройками индексации для своего сайта, включая создание robots.txt файла, установку мета-тега noindex и многое другое.

Также существуют и другие сервисы, такие как Яндекс.Вебмастер или Bing Webmaster Tools, которые предоставляют аналогичные возможности для сайтов в поисковых системах Яндекс и Bing соответственно.